RabbitMQ 简介

【简单】RabbitMQ 是什么?⭐

RabbitMQ 是一个开源的消息队列中间件,基于 AMQP(Advanced Message Queuing Protocol,高级消息队列协议)标准实现。

2025/9/19大约 30 分钟

RabbitMQ 是一个开源的消息队列中间件,基于 AMQP(Advanced Message Queuing Protocol,高级消息队列协议)标准实现。

Dubbo 是一款高性能、轻量级的开源 Java RPC 框架。

Dubbo 提供了三大核心能力:

什么是服务注册与发现?

服务注册与发现是微服务的核心基础设施,通过解耦服务地址硬编码,实现动态扩缩容和故障自动恢复。

订单服务启动后,向注册中心注册:"order-service: 192.168.1.100:8080"。支付服务需要调用订单服务时,从注册中心获取所有可用的order-service节点列表。

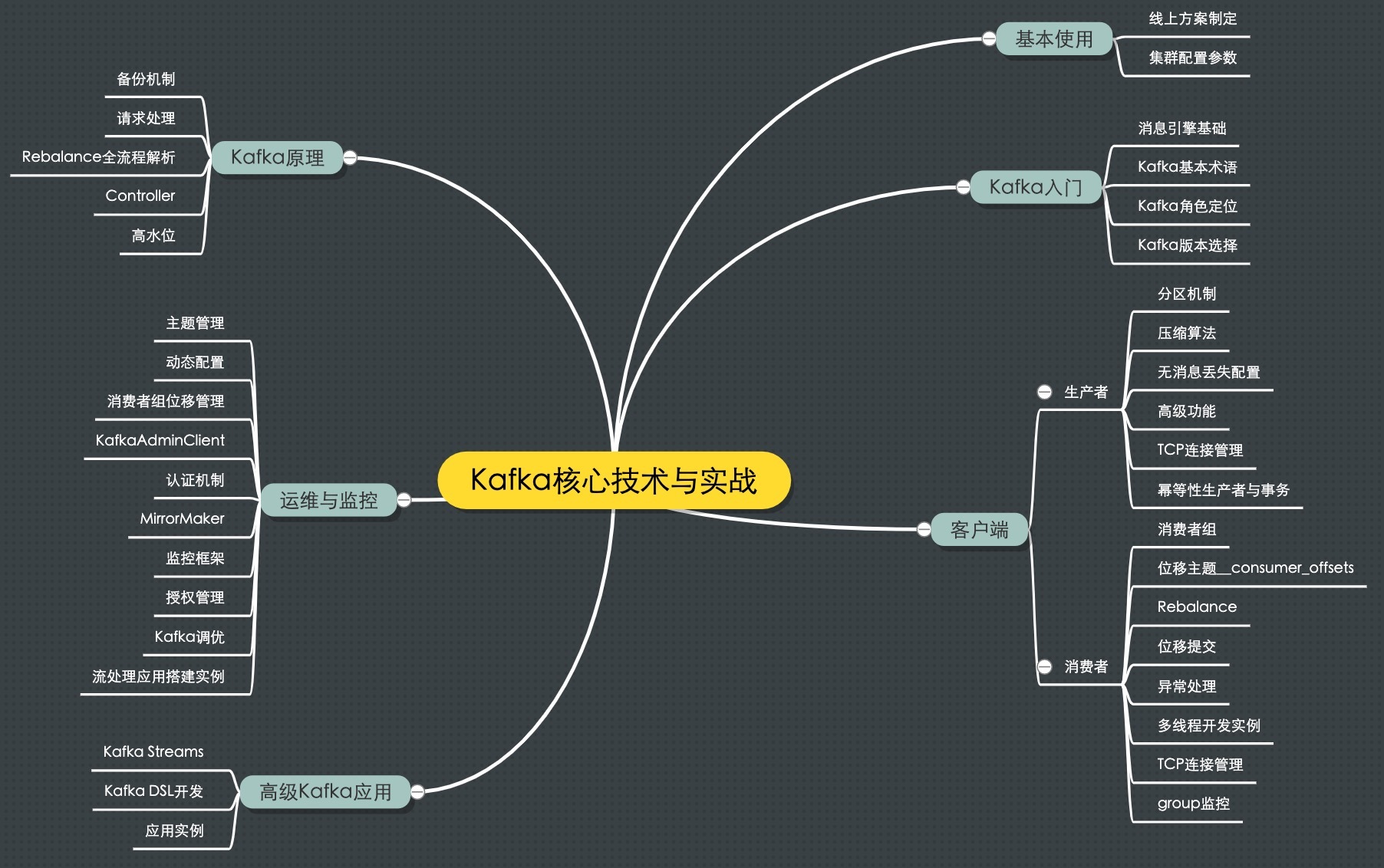

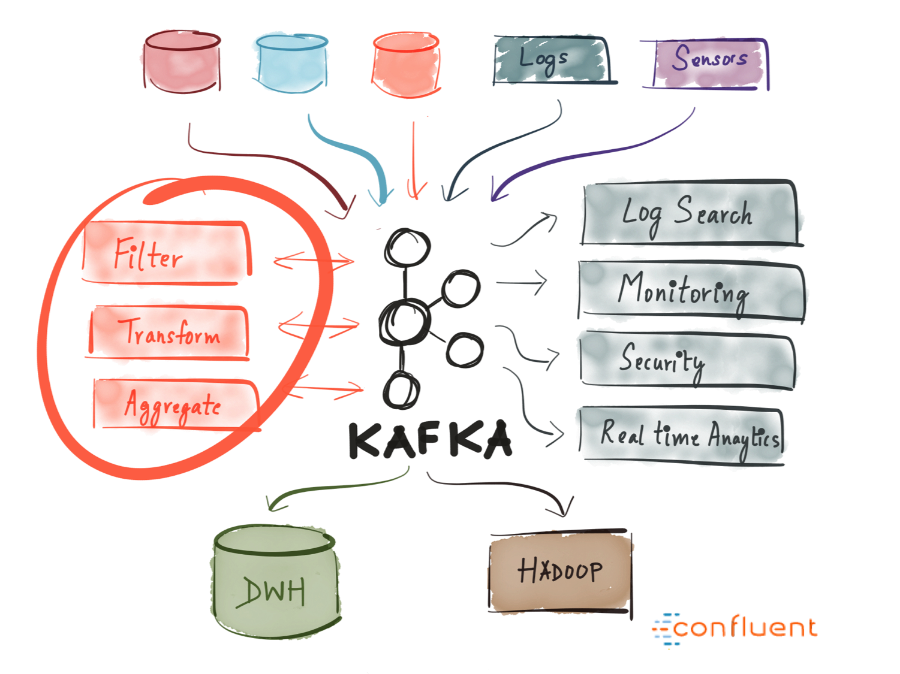

消息引擎系统的作用:

Kafka 是一个开源分布式事件流平台。最初由 LinkedIn 开发,现在是 Apache 顶级项目。

RPC 的全称是 Remote Procedure Call,即远程过程调用。

RPC 的主要作用是:

RPC 是微服务架构的基石,它提供了一种应用间通信的方式。

Apache Dubbo是一款高性能、轻量级的开源 Java RPC 框架,它提供了三大核心能力:

Dubbo 是一个分布式服务框架,致力于提供高性能、透明化的 RPC 远程服务调用方案以及服务治理方案,以帮助我们解决微服务架构落地时的问题。

broker:broker 模块(broker 启动进程) 。client:消息客户端,包含生产者、消息消费者相关类。common:公共包。dev:开发者信息(非源代码) 。distribution:部署实例文件夹(非源代码) 。example:RocketMQ 示例代码。filter:消息过滤相关基础类。filter:消息过滤服务器实现相关类(Filter 启动进程) 。logappender:日志实现相关类。namesrv:N ameServer 实现相关类(Names 巳 rver 启动进程) 。openmessaging:消息开放标准,正在制定中。remoting:远程通信模块,基于 Netty 。srvutil:服务器工具类。store:消息存储实现相关类。style:checkstyle 相关实现。test:测试相关类。tools:工具类,监控命令相关实现类。RocketMQ 是一个开源分布式消息中间件。最初由阿里巴巴开发,现在是 Apache 顶级项目。

RocketMQ 的核心概念