- Java197

- 编程8

- 设计78

- DevOps8

- 数据结构和算法16

- 数据库101

- 网络19

- 分布式74

- 大数据33

- 软件工程3

- 工作8

- 笔记30

- JavaSE61

- JavaEE15

- 软件20

- 工具37

- 框架68

- 中间件9

- 编程范式4

- 编程语言3

- Python6

- 架构31

- 设计模式27

- 重构7

- DDD2

- UML4

- 综合22

- 监控2

- 线性表4

- 树6

- 数据库综合3

- 数据库中间件4

- 关系型数据库20

- 文档数据库12

- KV数据库19

- 列式数据库14

- 搜索引擎数据库25

- 网络综合8

- 网络协议6

- 网络技术4

- 操作系统13

- 操作系统应用2

- 分布式综合3

- 分布式理论12

- 分布式协同13

- 分布式调度6

- 分布式高可用1

- 分布式通信31

- 分布式存储7

- hadoop7

- hive8

- spark1

- flink9

- 其他15

- 人工智能1

- 基础特性15

- 高级特性7

- 容器7

- IO10

- 并发12

- JVM12

- JavaWeb6

- 服务器8

- 构建9

- IDE4

- 监控诊断6

- JavaBean2

- 模板引擎4

- 测试5

- Spring61

- ORM3

- 安全8

- 缓存5

- 流量控制2

- 微服务5

- 解决方案8

- Git3

- Shardingsphere2

- Mysql10

- 数据库``1

- MongoDB11

- Redis17

- HBase12

- Elasticsearch16

- Elastic8

- Linux11

- 命令1

- 分布式协同综合6

- ZooKeeper6

- RPC8

- MQ17

- hdfs4

- 效能6

- 方法论2

- 规范3

- Tomcat6

- Maven7

- Spring综合5

- Spring核心24

- Spring数据10

- SpringWeb8

- SpringIO4

- Spring集成4

- Spring安全1

- Spring其他4

- RPC综合4

- Dubbo2

- MQ综合2

- Kafka9

- RocketMQ4

- 其他MQ1

服务路由

服务路由简介

什么是服务路由

服务路由是指通过一定的规则从集群中选择合适的节点。

为什么需要服务路由

负载均衡的作用和服务路由的功能看上去很近似,二者有什么区别呢?

负载均衡的目标是提供服务分发而不是解决路由问题,常见的静态、动态负载均衡算法也无法实现精细化的路由管理,但是负载均衡也可以简单看做是路由方案的一种。

服务路由通常用于以下场景,目的在于实现流量隔离:

- 分组调用:一般来讲,为了保证服务的高可用性,实现异地多活的需求,一个服务往往不止部署在一个数据中心,而且出于节省成本等考虑,有些业务可能不仅在私有机房部署,还会采用公有云部署,甚至采用多家公有云部署。服务节点也会按照不同的数据中心分成不同的分组,这时对于服务消费者来说,选择哪一个分组调用,就必须有相应的路由规则。

- 蓝绿发布:蓝绿发布场景中,一共有两套服务群组:一套是提供旧版功能的服务群组,标记为绿色;另一套是提供新版功能的服务群组,标记为蓝色。两套服务群组都是功能完善的,并且正在运行的系统,只是服务版本和访问流量不同。新版群组(蓝色)通常是为了做内部测试、验收,不对外部用户暴露。

- 如果新版群组(蓝色)运行稳定,并测试、验收通过后,则通过服务路由、负载均衡等手段逐步将外部用户流量导向新版群组(蓝色)。

- 如果新版群组(蓝色)运行不稳定,或测试、验收不通过,则排查、解决问题后,再继续测试、验收。

- 灰度发布:灰度发布(又名金丝雀发布)是指在黑与白之间,能够平滑过渡的一种发布方式。在其上可以进行 A/B 测试,即让一部分用户使用特性 A,一部分用户使用特性 B:如果用户对 B 没有什么反对意见,那么逐步扩大发布范围,直到把所有用户都迁移到 B 上面来。灰度发布可以保证整体系统的稳定,在初始灰度的时候就可以发现、调整问题,以保证其影响度。要支持灰度发布,就要求服务能够根据一定的规则,将流量隔离。

- 流量切换:在业务线上运行过程中,经常会遇到一些不可抗力因素导致业务故障,比如某个机房的光缆被挖断,或者发生着火等事故导致整个机房的服务都不可用。这个时候就需要按照某个指令,能够把原来调用这个机房服务的流量切换到其他正常的机房。

- 线下测试联调:线下测试时,可能会缺少相应环境。可以将测试应用注册到线上,然后开启路由规则,在本地进行测试。

- 读写分离。对于大多数互联网业务来说都是读多写少,所以在进行服务部署的时候,可以把读写分开部署,所有写接口可以部署在一起,而读接口部署在另外的节点上。

流量控制

在高并发场景下,为了应对瞬时海量请求的压力,保障系统的平稳运行,必须预估系统的流量阈值,通过限流规则阻断处理不过来的请求。

限流简介

什么是流量控制

流量控制(Flow Control),根据流量、并发线程数、响应时间等指标,把随机到来的流量调整成合适的形状,即流量塑形。避免应用被瞬时的流量高峰冲垮,从而保障应用的高可用性。

流量控制有以下几个角度:

- 流量指标,例如 QPS、并发线程数等。

- 资源的调用关系,例如资源的调用链路,资源和资源之间的关系,调用来源等。

- 控制效果,例如排队等待、直接拒绝、Warm Up(预热)等。

分布式 ID 基本原理

传统数据库软件开发中,主键自动生成技术是基本需求。而各个数据库对于该需求也提供了相应的支持,比如 MySQL 的自增键,Oracle 的自增序列等。

数据分片后,不同数据节点生成全局唯一主键是非常棘手的问题。同一个逻辑表内的不同实际表之间的自增键由于无法互相感知而产生重复主键。 虽然可通过约束自增主键初始值和步长的方式避免碰撞,但需引入额外的运维规则,使解决方案缺乏完整性和可扩展性。

为此,需要使用分布式 ID 来解决此问题。本文总结业界常用的分布式 ID 解决方案。

分布式会话基本原理

由于 Http 是一种无状态的协议,服务器单单从网络连接上无从知道客户身份。

会话跟踪是 Web 程序中常用的技术,用来跟踪用户的整个会话。常用会话跟踪技术是 Cookie 与 Session。

Cookie

由于 Http 是一种无状态的协议,服务器单从网络连接上无从知道客户身份。

所以服务器与浏览器为了进行会话跟踪(知道是谁在访问我),就必须主动的去维护一个状态,这个状态用于告知服务端前后两个请求是否来自同一浏览器。而这个状态需要通过 cookie 或者 session 去实现。

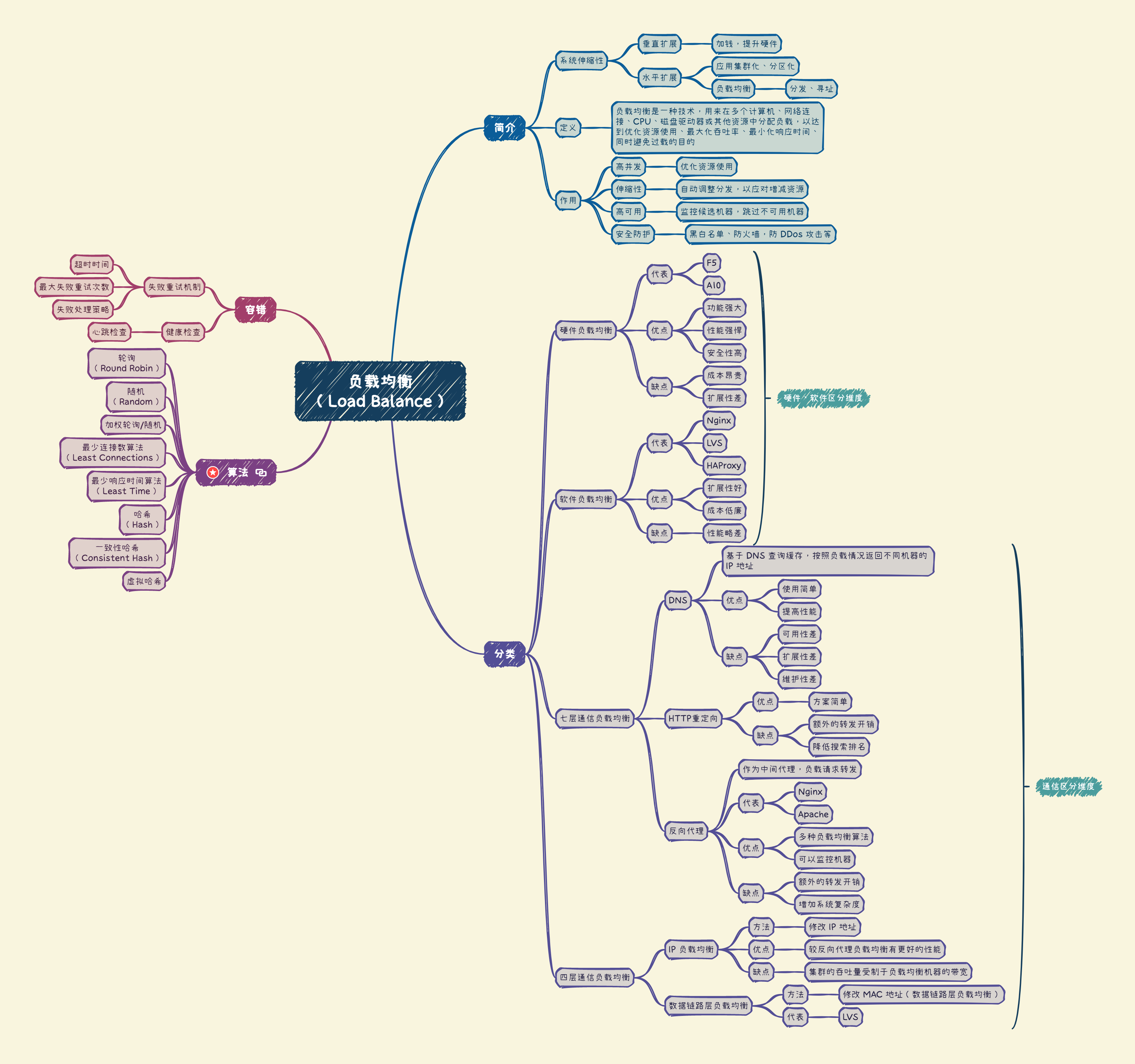

深入浅出负载均衡

负载均衡简介

大型系统面临的挑战

大型系统通常要面对高并发、高可用、海量数据等挑战。

为了提升系统整体的性能,可以采用垂直扩展和水平扩展两种方式。

- 垂直扩展:在网站发展早期,可以从单机的角度通过提升硬件处理能力,比如 CPU 处理能力,内存容量,磁盘等方面,实现机器处理能力的提升。但是,单机是有性能瓶颈的,一旦触及瓶颈,再想提升,付出的成本和代价会极高。通俗来说,就三个字:得加钱!这显然不能满足大型分布式系统(网站)所有应对的大流量,高并发,海量数据等挑战。

- 水平扩展:通过集群来分担大型网站的流量。集群中的应用机器(节点)通常被设计成无状态,用户可以请求任何一个节点,这些节点共同分担访问压力。水平扩展有两个要点:

- 集群化、分区化:将一个完整的应用化整为零,如果是无状态应用,可以直接集群化部署;如果是有状态应用,可以将状态数据分区(分片),然后部署到多台机器上。

- 负载均衡:集群化、分区化后,要解决的问题是,请求应该被分发(寻址)到哪台机器上。这就需要通过某种策略来控制分发,这种技术就是负载均衡。